- Veröffentlicht am

- • How2-Tipps

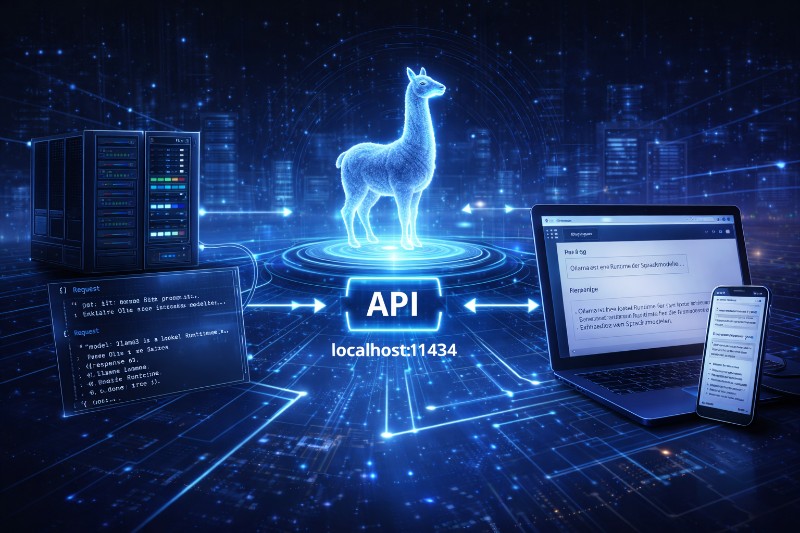

Ollama als Server & API nutzen – Lokale KI als echtes Backend

- Autor

-

-

- Benutzer

- tmueller

- Beiträge dieses Autors

- Beiträge dieses Autors

-

Warum Ollama erst als Backend richtig stark wird

Bis hierhin hast du Ollama wahrscheinlich interaktiv genutzt:

ollama run, ein bisschen Chat, ein paar Tests.

Das ist nett – aber nicht der eigentliche Zweck.

Die wahre Stärke von Ollama zeigt sich erst, wenn du es als Server und API betreibst. Ab diesem Moment ist Ollama kein Spielzeug mehr, sondern Infrastruktur.

Ollama als Server starten

Der entscheidende Befehl:

ollama serve

Was passiert dabei?

- Ollama startet einen lokalen HTTP-Server

- Standardadresse: http://localhost:11434

- Modelle werden on demand geladen

- Mehrere Clients können gleichzeitig zugreifen

👉 Ollama läuft jetzt dauerhaft im Hintergrund – wie eine Datenbank oder ein Webserver.

Die REST-API im Überblick

Ollama stellt eine einfache, saubere REST-API bereit.

Zentrale Endpoint-Logik

/api/generate→ Textgenerierung/api/chat→ Chat-basierte Interaktion/api/tags→ verfügbare Modelle/api/pull→ Modelle laden

Du brauchst:

- kein SDK

- keine spezielle Library

- kein Vendor-Lock-in

👉 HTTP + JSON reichen völlig.

Requests & Responses verstehen

Beispiel: Einfacher Generate-Request

POST /api/generate

{

"model": "llama3",

"prompt": "Erkläre Ollama in drei Sätzen."

}

Typische Response (gekürzt)

{

"response": "Ollama ist eine lokale Runtime für Sprachmodelle...",

"done": true

}

Wichtig:

- Kein versteckter Kontext

- Keine automatische Optimierung

- Keine Nachbearbeitung

👉 Du bekommst roh, was das Modell liefert.

Streaming vs. Blocking – ein wichtiger Unterschied

Ollama unterstützt zwei Betriebsarten.

Blocking (Standard)

- Request wartet

- Response kommt komplett zurück

- einfach, aber träge

Geeignet für:

- Skripte

- Batch-Jobs

- Hintergrundverarbeitung

Streaming

- Antwort kommt Token für Token

- sofortige Ausgabe

- UI wirkt „lebendig“

Beispiel:

{

"stream": true

}

Geeignet für:

- Chat-UIs

- Webinterfaces

- Live-Anwendungen

👉 Für Nutzerinteraktion fast immer Streaming nutzen.

Warum das API-Modell so mächtig ist

Ab jetzt kannst du Ollama:

- in Webapps einbinden

- aus Node-RED ansprechen

- mit n8n automatisieren

- aus PHP, Python, Go, JS nutzen

- als RAG-Backend einsetzen

Ollama wird damit:

ein KI-Dienst – kein Chatfenster.

Sicherheit: Lokal heißt nicht automatisch sicher

Ein häufiger Denkfehler:

„Läuft lokal, also egal.“

Falsch.

Standardverhalten

- Ollama lauscht auf

localhost - von außen nicht erreichbar

- keine Authentifizierung nötig

Das ist bewusst so.

Wenn du Ollama im Netzwerk freigibst

Dann musst du handeln:

- Reverse Proxy (z. B. Nginx)

- Zugriffsbeschränkung

- Firewall-Regeln

- ggf. Auth-Header

- kein öffentliches Internet ohne Schutz

👉 Ollama ist kein Public-API-Server von Haus aus.

Typische Architektur (praxisnah)

Bewährtes Setup:

Frontend / Tool

↓

Eigene Backend-Logik

↓

Ollama API

↓

Modell

Warum dieser Umweg wichtig ist:

- Prompt-Kontrolle

- Kontext-Management

- Logging

- Sicherheit

- Austauschbarkeit des Modells

👉 Nie direkt das Frontend mit Ollama sprechen lassen.

Fazit: Ab hier wird Ollama ernsthaft nutzbar

Sobald du Ollama als Server betreibst:

- verschwindet die CLI in den Hintergrund

- wird KI ein Systembaustein

- bekommst du Kontrolle & Skalierbarkeit

- kannst du reproduzierbar arbeiten

Oder anders gesagt:

Chat ist nur der Einstieg. API ist der eigentliche Job.