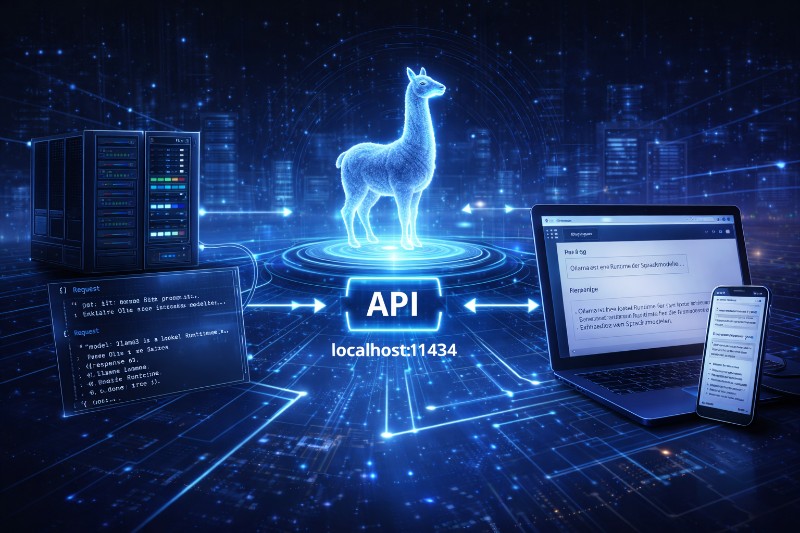

Warum Ollama erst als Backend richtig stark wird Bis hierhin hast du Ollama wahrscheinlich interaktiv genutzt:

ollama run, ein bisschen Chat, ein paar Tests. Das ist nett – aber nicht der

-

-

Wer Open WebUI sinnvoll einsetzen will, sollte nicht nur wissen, was es kann, sondern auch wie es intern arbeitet. Genau hier trennt sich schnell Spielerei von professionellem Einsatz. In diesem Teil

-

Warum gutes Prompting mehr bringt als ein größeres Modell Wer von ChatGPT zu Ollama wechselt, macht fast immer denselben Fehler: Er nutzt dieselben Prompts – und wundert sich über schlechtere

-

Was ist Open WebUI? – Die Open-Source-Oberfläche für lokale KI Künstliche Intelligenz ist längst im Alltag angekommen. Texte schreiben, Code erklären, Dokumente zusammenfassen oder Wissen

-

Cloud-KI ist bequem, aber nicht immer ideal: Datenschutz, API-Kosten und Internetabhängigkeit sind häufige Kritikpunkte. Wer lieber lokal mit eigenen Modellen arbeiten möchte, bekommt mit der

-

Was ist Ollama wirklich? (Und was nicht) Einordnung statt Marketing Ollama wird oft in einem Atemzug mit ChatGPT genannt. Manche nennen es „ChatGPT zum Selberhosten“, andere „die lokale KI

-

In der Welt der Künstlichen Intelligenz herrscht kein Mangel an mächtigen Tools. Doch während ChatGPT die Cloud dominiert und Ollama die lokale Nutzung revolutioniert, versucht AnythingLLM, das

-

In der wachsenden Landschaft von KI-Tools, APIs und Agenten-Frameworks verliert man schnell den Überblick. Zwischen OpenAI, Ollama, LangChain, LocalGPT und zahllosen RAG-Implementierungen

-

Ollama ist ein modernes Tool, mit dem sich große Sprachmodelle (LLMs) wie LLaMA, Mistral oder Code Llama lokal auf dem eigenen Rechner ausführen lassen – ganz ohne Cloud, API-Gebühren oder